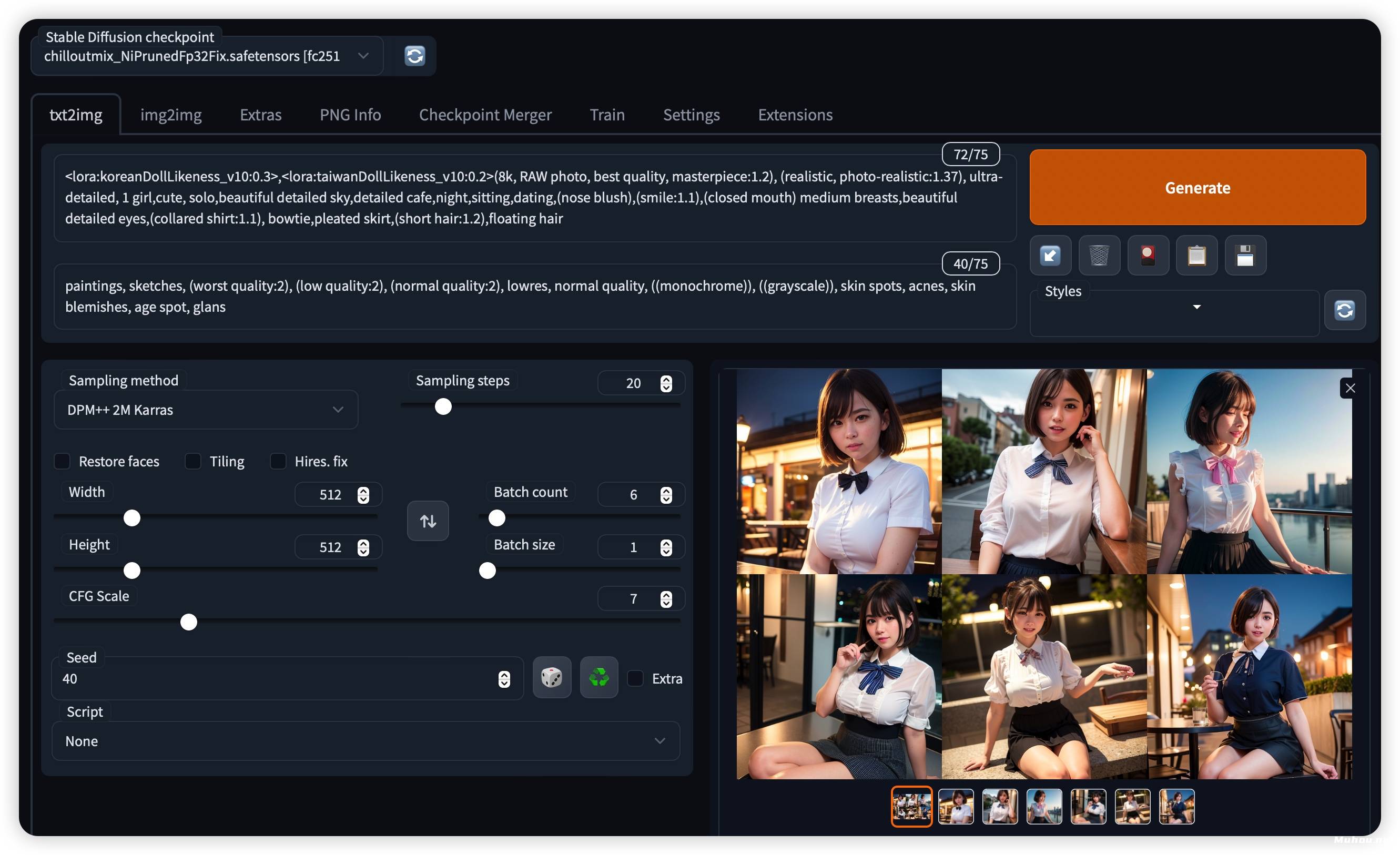

AI绘画软件Stable Diffusion+WebUI+Chilloutmix/ControlNet模型(一键安装包)支持WIN/MAC

Windows, Linux. Mac

显卡最好Nvidia,MAC最好是M1和M2,内存越大越好

进群交流出图参数,模型分享,技术问题讨论等~

软件指的通常是一个安装后能够在浏览器中打开的程序,最知名的是 stable-diffusion-webui 大部分的安装包都是这个或者基于这个的。

WINDOWS系统:

MAC系统安装教程:

stable-diffusion-webui 一键安装版+Homebrew国内安装包

以下安装比较复杂,如果不会可联系客服远程(另收费)

20220303更新中文版切换方法:

1.下载好最新版的stable-diffusion-webui

2.打开终端输入命令:Homebrew安装命令:

omebrew卸载命令:

3.随便选择一个源,然后按照流程按照后重启。

4.安装python,如果提示错误Command failed with exit 128:git,请参考解决办法

5.下载底部mac版本安装包,解压后用cd命令进入目录cd stable-diffusion-webui然后./webui.sh运行Web UI。 将使用venv创建和激活Python虚拟环境,任何剩余的缺失依赖项将自动下载和安装

6.要稍后重新启动Web UI进程,请再次运行./webui.sh。请注意,它不会自动更新Web UI;要更新,请在运行./webui.sh之前运行git pull

注:如果卡在Installing gfpgan,可以尝试以下方法:

1.挂上梯子,开全局科学上网

切换到stable-diffusion-webui目录,手动安装依赖

升级php3

python3.10 -m pip install --upgrade pip

手动安装依赖

pip install -r requirements_versions.txt

如果卡在clip,可以用下面这个命令~

pip install open_clip_torch

2.如果不行,查看下文

7.全部安装完成后在浏览器输入:http://127.0.0.1:7860/即可进入程序

注:部分m1机型无法生成,报错

RuntimeError:“LayerNormKernelImpl”未为“Half”

可使用sh webui.sh --skip-torch-cuda-test --no-half --use-cpu all命令启动

方法1:在文件目录:解压路径->extensions目录 下右键,打开powershell 在其中输入 (前提已安装git)

方法2:WebUl->扩展->从网址安装->git仓库链接输入->等待安装完成之后到已安装应用并重启用户界面

方法3:WebUl->扩展->可用->点击加载自->找到control net并安装->到已安装,应用并重启用户界面

这些方法完成之后,都需要去下载额外模型放在 解压路径->extensions目录->sd-webui-controlnet->models目录下

Q1:为什么我们要本地部署?

A1:stable diffusion本地部署的运行完全基于用户的本地电脑,给使用者带来极大的自由度,比如可以使用不同的微调模型,同时也能有效避免你的创作作品泄露。

Q2:本地部署的stable diffusion WEBUI和在线版有什么不同?

A2: stable diffusion WEBUI是典型的开源集成,一个月内迭代几十次,增加一大堆功能。标准化的本地部署能让你体验到这个和创新同步的过程。这是很多懒人版直接解压版本(无法用git升级)和网页版无法带给你的。

描述(画人体必须添加,不然很难看,景物不需要):lowres, bad anatomy, bad hands, text, error, missing fingers, extra digit, fewer digits, cropped, worst quality, low quality, normal quality, jpeg artifacts, signature, watermark, username, blurry

Q&AQ:画出来的不好看是怎么回事?A:没添加负词,或者描述太少,描述写的不行,或者步数跟分辨率设置的太低

Q:画出来的图是黑的怎么回事?A:那是因为你触发了nsfw,不可以瑟瑟

Q:描述应该怎么写?A:举例吧:1,一艘科幻与魔法结合的飞艇飞行在城市上空,美丽,杰作,梦幻般的,城市,月球,pixiv,8K,虚幻引擎渲染。2,梦幻般的动漫风格可爱少女,封面艺术,上半身图像,完美可爱的脸,猫耳朵,白色头发。把上面的描述翻译成英文就行了

Q:想要其它的绘画SD模型在哪去搞?A:百度、哔哩哔哩、github或者等好心人分享给你

Q:跟NovelAI官网付费版有啥区别吗?A:有区别,官网版本会擅自给你添加别的描述润色,所以风格比较统一。然后就是本地的不要钱

Q:怎么闪退,加载失败?A:我也不知道,我自己使用倒是很正常。看看有啥别的大佬能解决吧

以上只是下载了操作界面,要画图,还要用到模型,找到要用的模型,下载后放到对应的文件之后,在画图前选择好要用的模型,输入Prompt,点击Generate就可以了

有朋友问参数,关于炼模型我也在学习过程中,有说的不对的地方,敬请谅解。

首先,推荐两个Github仓库,kohya-ss/sd-scripts和cloneofsimo/lora,模型是用第一个仓库训练的;第二个仓库详细阐述了LoRA的一些概念,有一定的指导意义。

我的训练流程:确定选题 -> 找素材 -> 归一化 -> 打tag -> 调参数 -> 炼模型 -> 观察损失率 -> 跑模型 -> 视情况迭代或重炼

前言

其实不管是选题还是训练参数很大程度受你可以利用的机器资源影响,比如我的显卡3070 8G,所以我没办法训练太泛用性的选题,因为我的batch size拉不上去。

打tag我用的是wd14-tagger,比DeepDanbooru强多了,强烈推荐。

下面简单和大家梳理一下我对参数的个人理解,仅供参考。

分辨率

在合理范围内应该是大一些比较好,但是受显存的制约,我一般使用576*576(64*9)。

batch size

1,显存就这么点,想大我也没办法,所以我的选题尽量使用单一概念,减少loss震荡无法收敛的可能。

network dim

这个值其实是LoRA(Low-Rank Adaptation)的Rank值,这个值并不影响生成质量,LoRA的基本原理是计算底模和微调模型的差异值,这个Rank(下称为r)值,主要影响的就是差异信息量,r值为信息量的系数,所以r值约小,微调的信息量也就越小,其模型效果约接近底模,拟合效果越差。

所以随着r值的增加,模型的记忆力也会随之增加,带来的副作用是训练时间、模型大小也会随之增加,但过大的r值可能导致过多的无用信息,容易导致模型过拟合,尤其是对于我们这种单一主体的训练。

所以你要根据你训练的目标来制定数值,不过可以肯定的是r值低于8-16时,欠拟合的可能性很大,我一般使用32。

steps与epoch

其实这个比较简单,steps=样本数 x 每个样本重复次数 x epoch,在LoRA训练中,样本数量不宜过大,我认为25-50样本数是一个合理的值,确定样本数量以后,根据cloneofsimo/lora的文章和很多网友的经验,steps的总数在2500-3500之间会有一个不错的效果,对于我们这种学习目标不是很复杂的,我认为2500 steps就可以了,所以你就可以反推出epoch和单样本重复数。

学习率

学习率的作用简单来说就是控制找最优解或局部最优解的一套变量,想进一步了解建议到网上找点文章看,LoRA的学习率不用像DB那么小,我认为在1e-4到1e-5之间就可以;说实话学习率虽然本身非常的科学,但是这个参数调起来非常的玄学,除了基础学习率以外,kohya-ss/sd-scripts还有几个参数是关于学习率的,分别是:

- lr_scheduler:学习率的动态变化曲线,说实话我感觉挺玄学的,可以找下不同算法的曲线图看下会有直观的理解,一般我推荐用余弦退火重启(cosine_with_restarts),也有人推荐用constant_with_warmup。

- text_encoder_lr:与文本编码器相关的学习率,前面说LoRA的学习率不用太低,但这个要低一点,推荐5e-5至1e-5。

尾声

说白了炼丹调参数是非常主观的东西,而且非常的看脸,只要不怕失败,多试试就行了。

登录可见下载资源信息, 现在去登录

带到手机上看

热门软件/插件

- City Rig 1.7 – Cinema 4D(C4D)建筑城市楼房绑定生成插件

- 宅男的福音!AI黑科技,视频去马赛克修复神器JAVPlayer+TecoGAN+TG-PLUS+VEAI+TG-Z415模型

- 花旦戏子3D模型

- RS渲染器永久版!Redshift(红移渲染器)WIN/MAC,中文稳定使用,支持C4D R21-2024等软件!

- [Android] Dream Face V3.4.1 AI照片动画师 让人像图片动起来!

- 秒变 AI 绘画大师,comfyui最新整合包+1000 套工作流下载!

- 最强AI绘画工具Fooocus强力汉化版+百G模型包,一键本地部署,可玩性极高!

- 三维动画制作软件 Autodesk Maya 2018 Win/Mac/Linux 英/中文+注册机版

- 40个公司内部精品怪物npc文件3D模型合辑

- 女性帅气的紧身全身皮革套装3D模型合辑

- Roberto Cavalli进口时尚欧式家具3D模型合辑

- 3DS Max插件-GPU渲染器工具 FStorm Render v1.5.6H

- 3DS MAX OC渲染器插件 Octane Render 2022.1

- HtoA阿诺德Houdini渲染插件 SolidAngle Houdini To Arnold v2.1.1 Win/Mac/Linux破解版

- ChatTTS增强版V2,批量导出srt,语速控制,情感控制,支持朗读数字,问题修复

- AE/PR插件:视频慢镜头无极变速插件 Twixtor Pro 7.5.2 win汉化版/Mac英文版

- AI修图软件Radiant Photo破解版+预设下载,支持PS插件

- Stable diffusion 4.8.7升级版来了!超多SD模型库+最新课程(Ai绘画无需部署,解压即用)

- 一键AI模特换衣OMS-Diffusion整合包,用AI实现你的小姐姐自由

- AI音视频转字幕小工具V1.2,支持上百种语言,生肉翻译神器

共 0 条评论